Dally konstatoval, že v tomto vývoji hrál překvapivě malou roli známý Moorův zákon, ale uplatnil se spíše Huangův zákon, představený v roce 2018 Jensenem Huangem, prezidentem společnosti Nvidia.

Využíváte už ve firmě autonomní agenty postavené na bázi umělé inteligence?

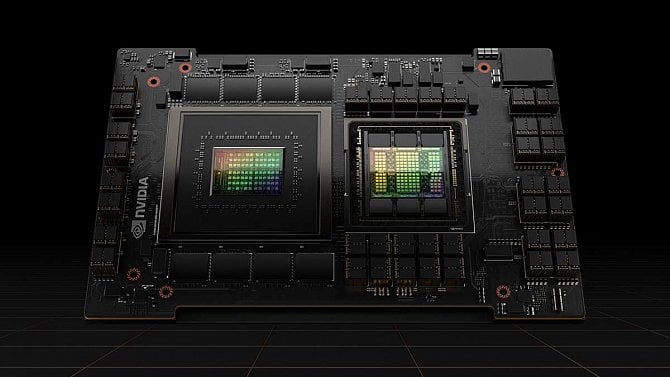

Huangův zákon umožnil zvyšování výkonu čipů nad predikce Moorova zákona kombinací vícero zdokonalení architektury, propojení, paměťových technologií a algoritmů, včetně formátu čísel používaného při výpočetních operacích. V důsledku toho se Nvidii za posledních 10 let podařilo tisícinásobně zlepšit výkon v úlohách AI.

Kde tedy můžeme hledat hlavní faktory tohoto úspěchu?

Reprezentace čísel

Nejdůležitějším objevem, který výkon čipů posunul 16násobně, byla lepší číselná reprezentace, uvedl Dally. Klíčové parametry neuronových sítí jsou vyjádřené v číselných formátech. Jedním z takových parametrů jsou váhy, které určují sílu propojení mezi neurony v modelu, a dalším jsou aktivace, během kterých dochází k násobení součtu vážených vstupů do neuronu, což určuje, zda se neuron zaktivuje a signál se rozšíří i do další vrstvy.

Před uvedením procesoru P100 byly tyto váhy reprezentovány jediným číslem s plovoucí desetinnou čárkou o standardní délce 32 bitů, definovaným normou IEEE 754, v němž 23 bitů představuje zlomek, 8 bitů slouží jako exponent zlomku a jeden bit kóduje znaménko čísla. Výzkum ale ukázal, že při různých výpočtech lze formát škálovat a mohou být úspěšně použita i méně přesná čísla, aniž by se zhoršily odpovědi dané neuronové sítě.

Při tomto postupu se násobení a sčítání, tedy klíčové operace strojového učení, zrychlí, protože se zpracovává méně bitů. V případě procesoru P100 se tedy Nvidii podařilo pomocí formátu FP16 snížit tento počet na polovinu. (S obdobnou technologií nazvanou Brain Floating Point Format neboli Bfloat16 přišel také Google.)

Nvidia ale šla o krok dále a vyvinula procesor Nvidia H100, který dokáže pracovat v 8bitovém formátu. Nicméně zjistila také, že toto řešení není univerzálně vhodné, takže architektura GPU Hopper ve skutečnosti počítá ve dvou různých formátech FP8, z nichž jeden má o něco větší přesnost a druhý o něco větší rozsah. Speciální know-how společnosti pak spočívá v tom, že ví, kdy jaký formát použít.

Chcete dostávat do mailu týdenní přehled článků z Computerworldu? Objednejte si náš mailový servis a žádná důležitá informace vám neuteče. Objednat si lze také newsletter To hlavní, páteční souhrn nejdůležitějších článků ze všech našich serverů. Newslettery si můžete objednat na této stránce.

Dalším způsobem, jak z menšího počtu bitů vymáčknout ještě více umělé inteligence, je nalezení takových reprezentací čísel, aby byly výpočty přesnější v blízkosti nuly. Důvodem je, že parametry neuronových sítí nevyužívají velká čísla, nýbrž se zpravidla pohybují právě v okolí 0.

Komplexní instrukce

Masívním vylepšením, které 12,5krát znásobilo výkon čipů, je použití komplexních instrukcí, kdy jsou velké výpočty prováděny pomocí jediné instrukce, a nikoliv jejich posloupností. „Režie načítání a dekódování instrukcí je totiž mnohonásobně vyšší než u jednoduchých aritmetických operacích,“ upřesnil Dally.

Poukázal na jeden typ násobení, který měl režii, jež vyžadovala plný 20násobek energie nutné na samotný výpočet. Podle něho je díky nové architektuře GPU režie u složitých instrukcí amortizována větším počtem matematických operací. Například složitá instrukce násobení a akumulace celočíselných matic (IMMA) má režii, která činí pouhých 16 % energetických nákladů na výpočet.

Moorův zákon

Konečně se dostáváme k samotnému Moorovu zákonu, který se ovšem zmenšováním součástek a zvyšováním jejich hustoty podílí na posunutí hranic výkonu GPU Nvidia podstatně méně (přibližně 2,5krát). Společnost aktuálně využívá nejmodernější dostupné výrobní technologie a H100 je vyroben 5nm procesem N5 společnosti TSMC.

Další posun bude znamenat příchod čipů 3nm generace, jejichž výrobu tento polovodičový gigant spustil teprve koncem roku 2022. Tato technologie zvyšuje hustotu logických obvodů o 70 % a v menším měřítku i hustotu obvodů paměťových.

Úspornost

Faktorem, který přispěl dvojnásobným nárůstem výkonu, je i úspornost samotné neuronové sítě. Po tréninku zůstane v neuronové síti vždy mnoho neuronů, které tam neplní žádnou funkci, takže u některých sítí je možné jich vyřadit až polovinu nebo více, aniž by došlo ke ztrátě přesnosti sítě. Hodnoty vah neuronů jsou nulové nebo se jim limitně blíží, takže žádným způsobem nepřispívají k výstupům sítě a jejich zahrnutí do výpočtů je plýtvání časem a energií.

Vytvořit tyto úsporné sítě snižující výpočetní zátěž je poměrně složitá záležitost. Ale už u modelu A100, předchůdce modelu H100, zavedla společnost Nvidia takzvanou strukturovanou úspornost. Jedná se o hardware, který v analogii k vývoji biologickému mozku vynucuje ořezávání nedůležitých spojení, což vede k menším nárokům na výpočetní složitost matic. Výzkum úspornosti by měl podle Dallyho vést ještě k dalším vylepšením.

Computerworld si můžete objednat i jako klasický časopis. Je jediným odborným měsíčníkem na českém a slovenském trhu zaměreným na profesionály v oblasti informačních a komunikačních technologií (ICT). Díky silnému zázemí přináší aktuální zpravodajství, analýzy, komentáře a přehledy nejnovejších technologií dříve a na vyšší odborné úrovni, než ostatní periodika na tuzemském trhu.

Obsah Computerworldu je určen odborníkům a manažerům z firem a institucí, kteří se podílejí na rozhodovacím procesu při nákupu ICT technologií. Jednotlivá čísla si můžete objednat i v digitální podobě.