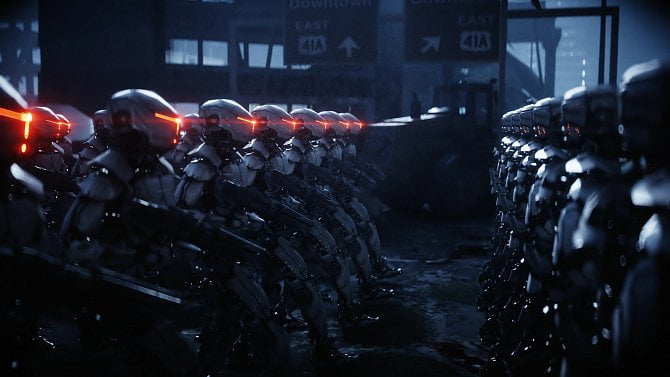

Více než desítka současných a bývalých zaměstnanců v oboru umělé inteligence podepsala otevřený dopis, v němž varuje, že nebezpečí této technologie může vést k „vyhynutí lidstva“.

Je podle vás regulace AI vhodnou metodou, jak zabezpečit AI?

Dopis napsalo 13 lidí, kteří pracovali ve společnostech OpenAI, Google DeepMind a Anthropic, což jsou přední poskytovatelé technologie generativní umělé inteligence (genAI). Konkrétně vyjádřili znepokojení nad řadou rizik plynoucích z umělé inteligence, od „dalšího upevňování stávajících nerovností, přes manipulaci a dezinformace až po ztrátu kontroly nad autonomními systémy umělé inteligence, která by mohla vést k vyhynutí člověka“.

„Samy společnosti zabývající se umělou inteligencí tato rizika připouštějí, stejně jako vlády po celém světě a další odborníci na umělou inteligenci,“ píše se v dopise.

Ten vyzývá také k ujištění, že zaměstnanci, kteří vznesou obavy, nebudou ze strany svých zaměstnavatelů postihováni. Dopis podpořili také vědec zabývající se umělou inteligencí Yoshua Bengio, britsko-kanadský počítačový vědec a psycholog Geoffrey Hinton a profesor informatiky na Kalifornské univerzitě Stuart Russell.

Nejnovější depeše je ozvěnou otevřeného dopisu vydaného v březnu 2023, kdy více než 150 předních výzkumníků AI a dalších osobností vyzvalo společnosti zabývající se genAI, aby se podrobily nezávislému hodnocení svých systémů, jehož absence vedla k obavám o základní ochranu.

Později téhož měsíce více než 1 000 signatářů, mezi nimiž byli odborníci z průmyslu, vědci, etici a další, zveřejnilo otevřený dopis varující před možnou „ztrátou kontroly nad naší civilizací“ v důsledku nekontrolované AI. A v otevřeném dopise z května 2023 řada nejvýznamnějších tvůrců této technologie označila její kontrolu za „globální prioritu vedle dalších rizik celospolečenského rozsahu, jako jsou pandemie a jaderná válka“.

Nový dopis upozornil, že neexistuje účinný vládní dohled nad korporacemi, které vytvářejí a prodávají AI řešení. „Současní a bývalí zaměstnanci jsou jedni z mála lidí, kteří je mohou pohnat k odpovědnosti před veřejností. Dohody o mlčenlivosti nám však brání vyjádřit své obavy, s výjimkou společností, které tyto dohody neřeší,“ uvedli signatáři. „Běžná ochrana whistleblowerů je nedostatečná, protože se zaměřuje na nezákonnou činnost, zatímco mnoho rizik, kterých se obáváme, zatím regulováno není. Někteří z nás se důvodně obávají různých forem odvetných opatření, vzhledem k historii takových případů napříč odvětvím. Nejsme první, kdo se s těmito problémy setkává nebo o nich mluví.“

Zaměstnanci stanovili čtyři konkrétní opatření, která od společností požadují, aby byla zajištěna bezpečnost genAI technologie:

- Společnost nebude uzavírat ani vymáhat žádnou dohodu, která by zakazovala „znevažování“ nebo kritiku společnosti kvůli obavám souvisejícím s riziky, ani nebude uplatňovat odvetná opatření za takovou kritiku.

- Společnost usnadní ověřitelně anonymní postup pro současné i bývalé zaměstnance, aby mohli vznášet obavy související s riziky představenstvu společnosti, regulačním orgánům a vhodné nezávislé organizaci s příslušnými odbornými znalostmi.

- Společnost bude podporovat kulturu otevřené kritiky a umožní svým současným i bývalým zaměstnancům vznášet obavy související s riziky týkajícími se jejích technologií veřejnosti, představenstvu společnosti, regulačním orgánům nebo vhodné nezávislé organizaci s příslušnými odbornými znalostmi, pokud jsou obchodní tajemství a jiné zájmy duševního vlastnictví náležitě chráněny.

- Společnost se nebude mstít současným a bývalým zaměstnancům, kteří veřejně sdílejí důvěrné informace související s riziky poté, co jiné postupy selhaly.

„Souhlasíme s tím, že obavy by měly být zpočátku vznášeny prostřednictvím takového procesu. Dokud však takový proces neexistuje, měli by si současní a bývalí zaměstnanci zachovat svobodu oznamovat své obavy veřejnosti,“ uvádí se v dopise.

Začátkem letošního roku se více než 200 společností a organizací dohodlo na účasti v konsorciu AI Safety Institute, jehož cílem je vytvořit pokyny zajišťující bezpečnost systémů umělé inteligence. Dosavadní účast však byla dobrovolná a USA jsou daleko pozadu za ostatními snahami o omezení potenciálních problémů AI. Například Evropská unie dokončila psaní zákona o umělé inteligenci před více než rokem; schválen byl v červnu 2023.

Zákon EU o umělé inteligenci vyžadoval, aby systémy genAI splňovaly standardy transparentnosti, které pomohou regulačním orgánům a dalším subjektům rozlišit podvrhy od skutečných snímků. Opatření rovněž zakazovalo systémy sociálního hodnocení a manipulativní AI.

Ve Spojených státech se objevilo několik snah o omezení AI, ale Kongres žádnou smysluplnou legislativu nepřijal. Například v říjnu 2023 vydal americký prezident Joe Biden exekutivní příkaz, který vytyčil jasná pravidla a dohledová opatření, jež mají zajistit, aby byla AI držena pod kontrolou, a zároveň poskytnout cesty pro její rozvoj.

Mezi více než dvěma desítkami iniciativ byl Bidenův příkaz Bezpečná, zabezpečená a důvěryhodná umělá inteligence podle odborníků z odvětví umělé inteligence, kteří vzestup nástrojů a platforem genAI sledují od konce roku 2022, dlouho očekávaný.

Chcete dostávat do mailu týdenní přehled článků z Computerworldu? Objednejte si náš mailový servis a žádná důležitá informace vám neuteče. Objednat si lze také newsletter To hlavní, páteční souhrn nejdůležitějších článků ze všech našich serverů. Newslettery si můžete objednat na této stránce.